Technik

September 12, 2025

Perfektes Lip Sync: Warum es so entscheidend ist – und woran die meisten Tools scheitern

Von „irgendwie passend“ zu wirklich synchron

Früher hieß Lip Sync: Man versuchte, die übersetzte Audiospur irgendwie auf die Lippenbewegungen des Originals anzupassen.

Das Ergebnis: viel Herumgeschiebe im Schnittprogramm – mit dem Ziel, dass wenigstens die Satzlänge grob passt.

Heute geht das anders.

KI macht es möglich, die Lippenbewegungen im Bild aktiv zu verändern – frame-genau, sprachspezifisch und nahezu unsichtbar.

So wirkt die übersetzte Version nicht nachträglich bearbeitet, sondern wie direkt in der Zielsprache aufgenommen. Vorausgesetzt, es ist perfekt gemacht.

Was ist Lip Sync eigentlich?

Lip Sync (kurz für „Lip Synchronization“) bezeichnet die Abstimmung von gesprochener Sprache und sichtbarer Mundbewegung im Video.

Das Ziel: Die Person im Bild wirkt, als würde sie genau das sagen, was man hört – unabhängig von der Originalsprache.

Dabei geht es nicht nur um Timing, sondern um:

- Artikulation (Welche Laute werden sichtbar gesprochen?)

- Satzmelodie und Pausen

- Mimik, Gesichtsausdruck und Bewegungsdynamik

Erst wenn all das zusammenpasst, entsteht der Effekt: Das fühlt sich echt an.

Warum gutes Lip Sync so entscheidend ist

Lip Sync ist kein netter Bonus. Es ist ein zentraler Baustein für:

- Glaubwürdigkeit: Schon kleinste Abweichungen zwischen Lippenbewegung und Ton irritieren – und wirken künstlich.

- Vertrauen: Besonders bei CEO-Videos, Schulungen oder Produktpräsentationen zählt der persönliche Eindruck.

- Professionelle Wirkung: Wenn Sprache und Gesicht nicht zusammenpassen, verliert dein Video sofort an Wirkung.

- Emotionale Bindung: Unser Gehirn liest Emotionen aus Gesichtern. Stimmt die Bewegung nicht zur Stimme, geht dieser Effekt verloren.

Gerade bei Formaten mit viel Face-to-Camera – etwa auf YouTube, in Webinaren oder Social Ads – ist starkes Lip Sync ein Muss.

Warum 80 % beim Lip Sync nicht reichen

Viele Tools schaffen es, grob den Takt zu treffen.

Aber bei Lip Sync reicht „ungefähr“ eben nicht.

- Ein einziger falsch synchronisierter Laut? Sofort sichtbar.

- Ein minimaler Versatz in den Lippenbewegungen? Wirkt unecht.

- Ein Satz, der visuell nicht zu Ende gesprochen wird? Irritiert.

Lip Sync muss zu 100 % stimmen – oder es funktioniert nicht.

Es gibt keine optische Fehlertoleranz. Menschen sind extrem sensibel für Gesichtsbewegungen. Was nicht passt, fällt sofort auf.

{{cta}}

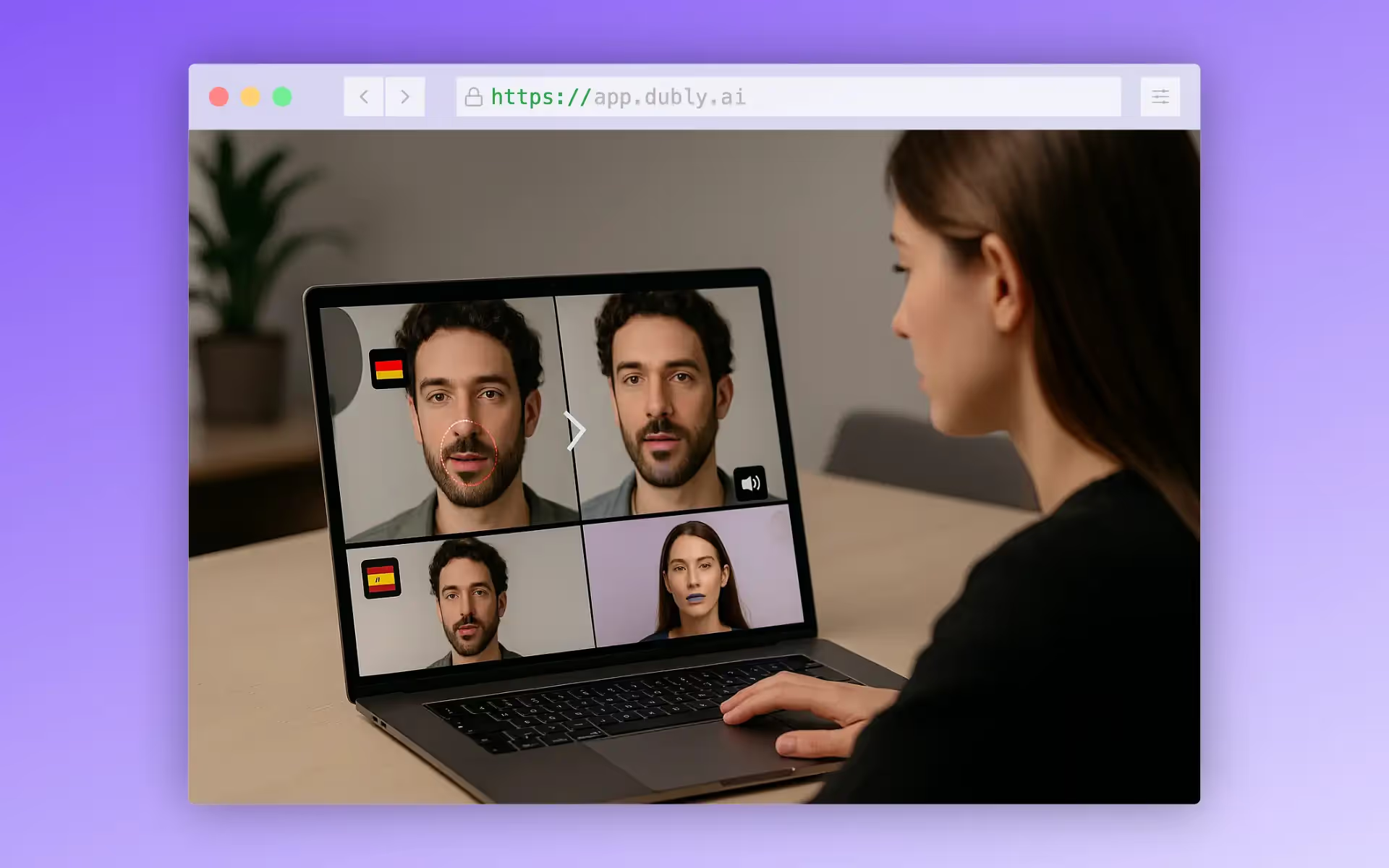

Wie Dubly.AI echtes Lip Sync erzeugt

Bei Dubly wird das Lip Sync erst ganz am Ende des Workflows erzeugt – also nachdem:

- das Video übersetzt wurde,

- die Audiospur optimiert ist,

- ggf. Voice Cloning angewendet wurde.

Dann analysiert das System:

- Die Lippenbewegungen im Originalvideo

- Die neue Sprachversion (Wortlaut, Betonung, Rhythmus)

- Kontext (Sprache, Satzstruktur, Gesichtsperspektive)

Basierend darauf wird die Lippenbewegung im Video präzise angepasst – mit fließender Bewegung, stimmigem Timing und natürlichem Look.

Das Ergebnis: ein Video, das sich anfühlt wie original in der Zielsprache produziert.

Warum andere Tools beim Lip Sync versagen

Viele Anbieter versprechen automatisiertes Lip Sync – liefern aber:

- Avatar-basierte Animationen (die nicht zum Original passen)

- starre Regeln („Ein Laut = eine Mundform“)

- grobe Audio-Timing-Anpassung ohne echte visuelle Justierung

Das sieht im besten Fall künstlich aus – im schlimmsten Fall nach Deepfake.

Dubly setzt stattdessen auf echte visuelle Intelligenz.

Keine Masken, keine Avatare – sondern echte Gesichter, die natürlich und überzeugend angepasst werden.

{{callout}}

Fazit: Lip Sync ist Pflicht, nicht Kür

Du kannst alles richtig machen – gute Übersetzung, starke Stimme, sauberes Editing – und trotzdem verliert dein Video Wirkung, wenn der Lip Sync nicht passt.

Dubly.AI liefert echten, präzisen Lip Sync – als letzten Schliff für hochwertige Videoproduktion in jeder Sprache.

Kein Flickwerk, kein „Wird schon reichen“, sondern echte Qualität für Unternehmen, Agenturen und Creator.

Was ist Lippensynchronisation wirklich?

Die Lippensynchronisierung ist die präzise Abstimmung zwischen gesprochenem Audio und Mundbewegungen im Video. Dabei müssen nicht nur der Zeitpunkt, sondern auch Phonetik, Ausdruck, Ton und Pausen aufeinander abgestimmt werden, sodass es so aussieht, als würde die Person den übersetzten Ton wirklich sprechen.

Was machen die meisten Tools falsch bei der Lippensynchronisierung?

Viele geben nur ungefähre Zeitangaben an, dehnen den Ton aus oder verwenden generische Regeln wie feste Mundformen. Andere überspringen die Anpassung der visuellen Mundbewegung komplett. Das Ergebnis ist eine roboterartige, distanzierte oder sich „aus“ fühlende Lippensynchronisation.

Wie erreicht Dubly.AI eine echte Lippensynchronisierung?

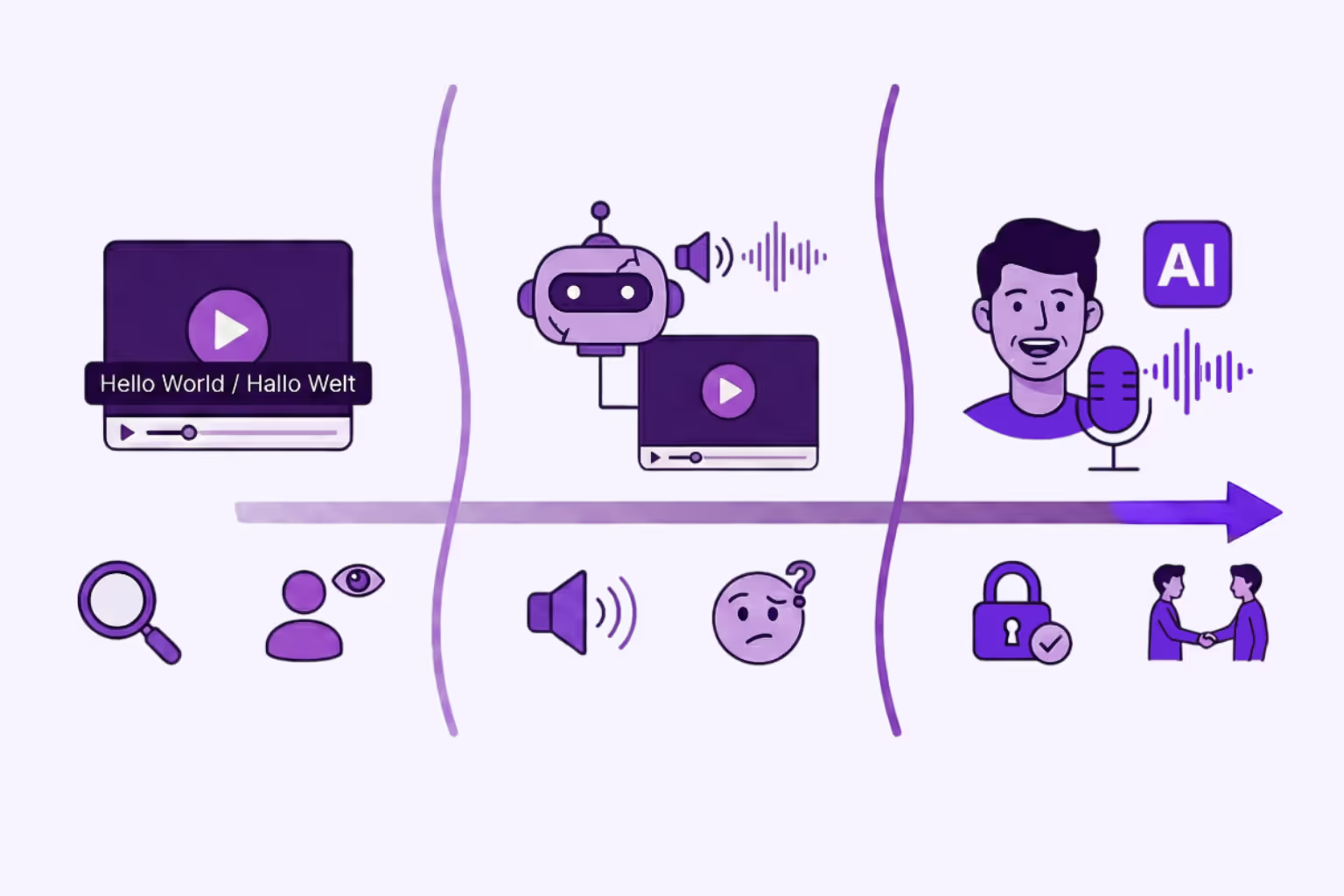

Dubly führt die Lippensynchronisierung als letzten Schritt nach der Übersetzung, der Optimierung der Sprachspur (und optional dem Klonen von Stimmen) aus. Das System analysiert die ursprünglichen Lippenbewegungen, den übersetzten Ton (Aussprache, Rhythmus, Phonetik) und den Kontext (Satzstruktur, Kamerawinkel) und passt dann die Lippen dynamisch Bild für Bild an, ohne andere Gesichtszüge zu verändern.

In welchen Situationen ist die Lippensynchronisation besonders wichtig?

Wenn Menschen direkt in die Kamera sprechen, in Führungsbotschaften, emotionalem Geschichtenerzählen, in Testimonials, Anzeigen, internationalen Inhalten für Plattformen wie YouTube oder soziale Medien oder überall dort, wo visuelle Authentizität zum Markenvertrauen beiträgt.

Über den Autor

Neueste Artikel

Technik

AI Lip Sync erklärt: Schluss mit asynchronen Lippen in Video-Übersetzungen

Asynchrone Videos wirken unprofessionell. Erfahre, wie AI Lip Sync und Visual Dubbing deine Übersetzungen perfektionieren – DSGVO-konform und skalierbar.

Simon Pieren

December 23, 2025

Anwendungen

How to Translate Video Free: 3 Ways to multiply your reach

Suchst du einen AI Video Translator? Wir zeigen, wie du Video kostenlos übersetzen kannst – mit 3 Methoden: Untertitel, Basis-TTS und professionellem Lipsync.

Simon Pieren

December 8, 2025

Anwendungen

Translate Video Free: Ein Leitfaden zu KI Übersetzung, Lip Sync & Voice Cloning

Suchen Sie nach „Video kostenlos übersetzen“? Lernen Sie die technischen Unterschiede zwischen Standard-Dubbing und generativem KI-Lip-Sync kennen und erfahren Sie, wie Sie professionelle Qualität risikofrei testen.

Simon Pieren

November 28, 2025